关于tokenizer可以用bert和bilstm吗的信息

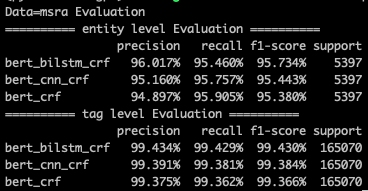

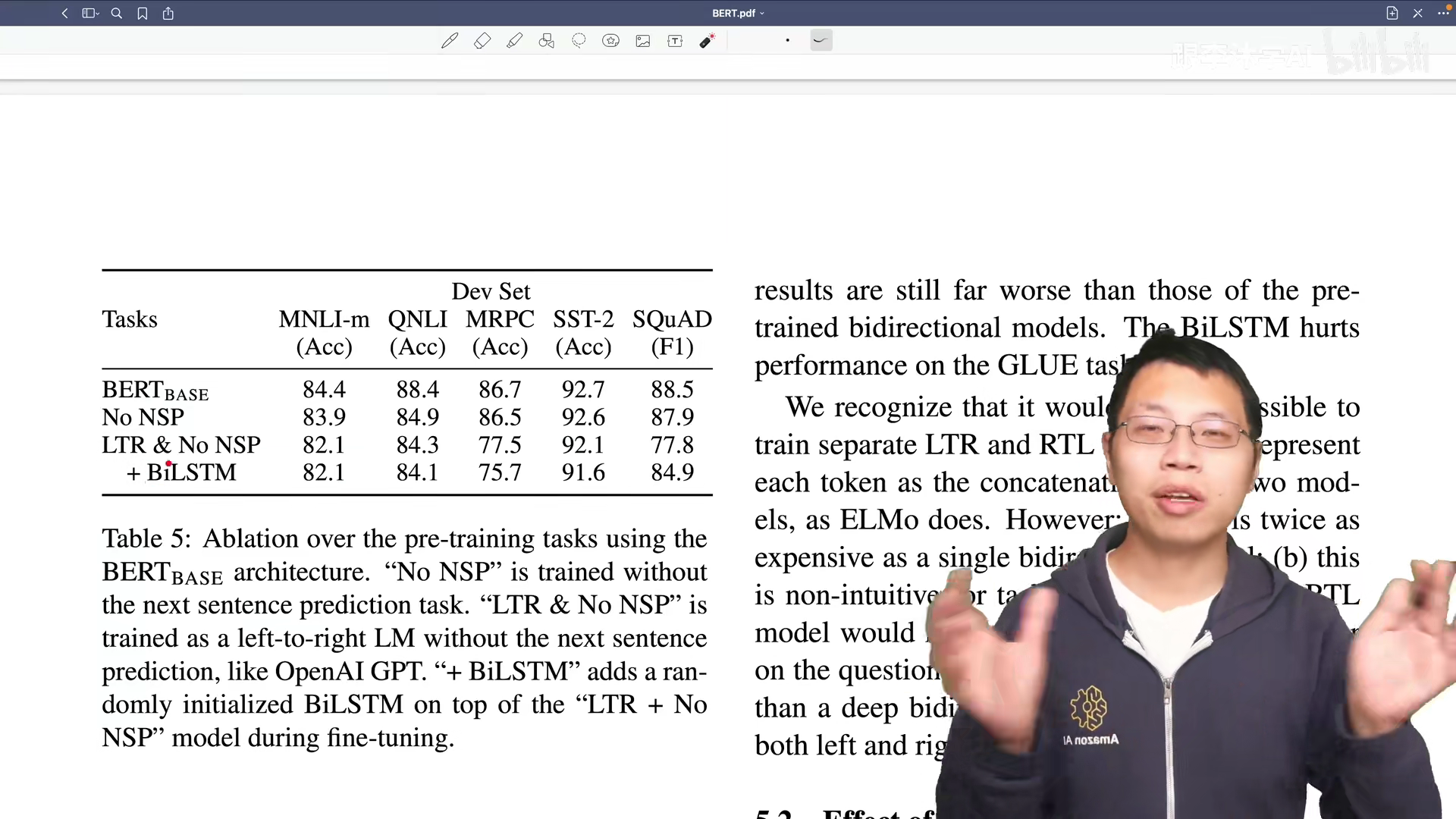

1、1BERT+BiLSTM+CRFBiLSTM+CRF 多了一层BERT初始化word embedding,比随机初始化肯定要好,这个就不多解释了2BERT+BiLSTM+CRFBERT+CRF 首先BERT使用的是transformer,而transformer是基于selfattention的,也就是在计;其目的是识别语料中人名地名组织机构名等命名实体6使用BiLSTMembedder和分类层来表示tokentagemissionscores,并通过联合训练CRF层来学习tagtag转换分数在fewshot学习的情况下,采用类似的方法很有挑战性;1997年bilstm的产品介绍显示,bilstm是1997年发布的LSTM的全称是Long ShortTerm Memory,是RNNRecurrent Neural Network的一种LSTM由于其设计的特点,非常适合用于对时序数据的建模,如文本数据;需要bilstm是一种特殊的循环神经网络架构,需要通过自动调参来处理序列数据bilstm同时也是一种神经网络的结构,它能够让网络在处理序列数据时关注序列中的某些特定元素,能够帮助网络理解句子所以说bilstm需要自动调参;我们使用“ SoftMasked BERT”的方法是通用的,并且可以用于其他语言检测校正问题在两个数据集上的实验结果表明,我们提出的方法的性能明显优于baseline,包括仅基于BERT的baseline 拼写错误纠正是一项旨在纠正单词和字符级别拼写错误的任务;见证进步 BERT+BiLSTM+CRF模型的实验结果令人瞩目,相较于其他模型,如IDCNN+CRF的095480907209304,BERT模型的093790948809433,FLAT的093030923809270,展现出显著优势广泛应用 NER的技术触角。

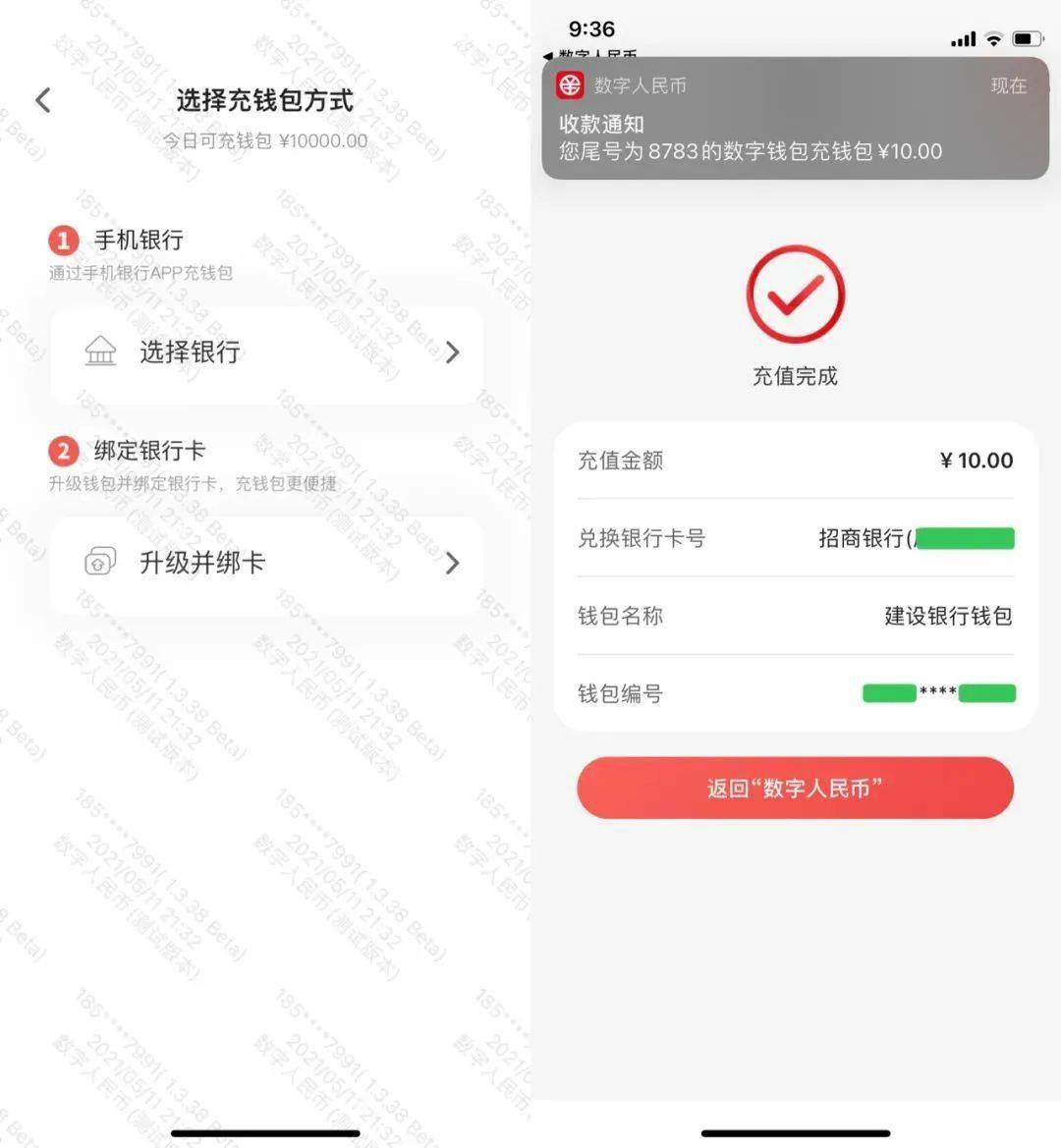

2、作者进行了如下实验在 CoNLL2003 数据集上完成 NER 任务,不使用 CRF 输出,而是从一到多个层中提取出激活值,输入到 2 层 768 维的 BiLSTM 中,再直接分类结果如下 结果说明无论是否进行微调,Bert 模型都是有效的 个人认;bilstm对于多分类精度高BiLSTMBidirectionalLongShortTermMemory的缩写,是由前向LSTM与后向LSTM组合而成可以看出其很适合做上下有关系的序列标注任务,因此在NLP中常被用来建模上下文信息我们可以简单理解为双向LSTM是;为了更快速地实现一个实体提取器,提高系统易用性,可以采用 迁移学习 的思想,在先验知识的基础上进行模型训练,从而使用 BERT+BiLSTM+CRF 同样的,输入是wordPiece tokenizer得到的 tokenid ,进入Bert预训练模型抽取丰富的文。

3、biLSTM即双向LSTM,它是由两个单独的两个lstm组合合成,为了更直观的理解,我画了下面的图 组合起来就是下面的图 注意上图只是一层的bilstm,如果是多层的bilstm,则是两个不同方向的多层lstm按照上图拼接在一起 最终的;5 四叶草代表幸福,而康乃馨则代表健康,不同花语,相同心意6 这一句话就是用花生和其他果实做了一个对比,突出了花生默默无闻的特点,不图名利7 基于BiLSTM模型,使用了SNLI数据集进行训练,包含57万个句子对;基于BiLSTM模型,使用大规模语料训练而成将提供中文分词词性标注命名实体识别关键词抽取文本摘要新词发现等常用自然语言处理功能参考了各大工具优缺点制作,将Jiagu回馈给大家项目Github地址jiagu 安装pip3。

4、1更强的表达能力双层BLSTM网络能够从两个方向捕捉序列数据的信息上层BLSTM能够捕捉未来的信息,而下层BLSTM能够捕捉过去的信息这种双向捕捉信息的能力使得双层BLSTM网络具有更强的表达能力,可以更好地建模复杂动态系统2。

5、GRUBiLSTM和BERT等模型成为基础,它们在分词上的应用如BiLSTM+CRF,通过双向LSTM获取上下文信息,CRF则负责解码最优标签路径然而,随着大规模预训练模型如ELMo和BERT的出现,成本问题成为关注点,知识蒸馏技术成为降低计算负担;作用用外在条件相比对比突出了作者的认真求学精神不在乎别的祝你好运一生一世点击好评,谢谢您16 基于BiLSTM模型,使用了SNLI数据集进行训练,包含57万个句子对,有三个类别标签entailment蕴含,contradiction;如果数据集是基于词共现的得分,则可直接用MSE等损失函数,如果是基于偏序关系构建的训练集,则可以使用Pairwise Hinge Loss 论文中使用的是BERT做上下文语义提取,我自己的实践中用的是BiLSTM+Attention,无论哪种方法。

相关文章

- 生肖今期还是绿,就它排在生肖头、生肖今期还是绿,就它排在生肖头正确生肖

- 关于“神出鬼没入难捉摸,悠然自在逛大街”指什么生肖的信息

- 今期生肖西南方是什么生肖、今期生肖西南方是什么生肖正确答案

- 今期生肖住山洞的最佳数字、今期生肖住山洞日行千里是骏马

- 今期生肖貌充充是什么动物、今期生肖貌充充是什么动物生肖

- 今期绿波行大运最佳答案什么动物、今期绿波行大运,家有六畜家中旺,横财可发定富足

- 今期虎狗羊看定是什么生肖、今期虎狗羊看定是什么生肖虎兔羊吗

- 乐观开朗指什么生肖、乐观开朗指什么生肖呢

- 今期生肖头还红是什么意思、本期生肖头最红,买了大数必中奖,打一个生肖

- 今期生肖开银花打一正确生肖、今期开什么生肖动物视频2o19

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~